- Home

- Metodología de investigación

- El ciclo de vida del dato: claves para una gestión pública basada en datos confiables

El ciclo de vida del dato: claves para una gestión pública basada en datos confiables

![]() Claudio MartinezData governance, Metodología de investigación, Gobierno digital4 months ago324 Views

Claudio MartinezData governance, Metodología de investigación, Gobierno digital4 months ago324 Views

La confiabilidad del dato: más que una cuestión técnica

¿Por qué es importante la confiabilidad de los datos, su trazabilidad, su origen y cómo este ha sido tratado, transformado o estandarizado? Es una pregunta recurrente, sobre todo cuando hablamos de datos públicos, datos necesarios para tomar decisiones que impactan en el día a día de millones de ciudadanas y ciudadanos.

Pero antes de seguir, hay que romper con algo: la confiabilidad del dato NO es un problema técnico que se resuelve con mejor infraestructura, con bases de datos más robustas o con algoritmos más sofisticados. Es, ante todo, una cuestión epistemológica y política. Hablo de epistemológica porque tiene que ver con cómo conocemos la realidad, con qué preguntas hacemos, con qué decidimos medir y —fundamentalmente— con qué decidimos NO medir. Y hablo de política porque cada dato que generamos, cada variable que elegimos, cada forma de clasificar, está cargada de una visión del mundo, de un recorte de la realidad que nunca es neutral.

Pierre Bourdieu lo planteaba claro cuando hablaba de cómo las categorías estadísticas del Estado construyen realidad social. No solo describen, producen formas de ver y entender lo social. Cuando un censo pregunta “jefe de hogar” en lugar de “persona responsable del hogar”, cuando una encuesta de salud no contempla identidades de género diversas, cuando un sistema de gestión de trámites no considera el analfabetismo digital, no estamos ante “errores técnicos”: estamos ante construcciones políticas que excluyen, invisibilizan o distorsionan realidades.

La confiabilidad, entonces, es la capacidad de sostener una trazabilidad crítica de todo el proceso de construcción del dato. No alcanza con documentar “de dónde salió el número”, hay que poder responder: ¿qué realidad social estamos intentando capturar? ¿Qué sesgos estructurales reproduce nuestro instrumento de medición? ¿A quiénes deja afuera esta forma de preguntar?.

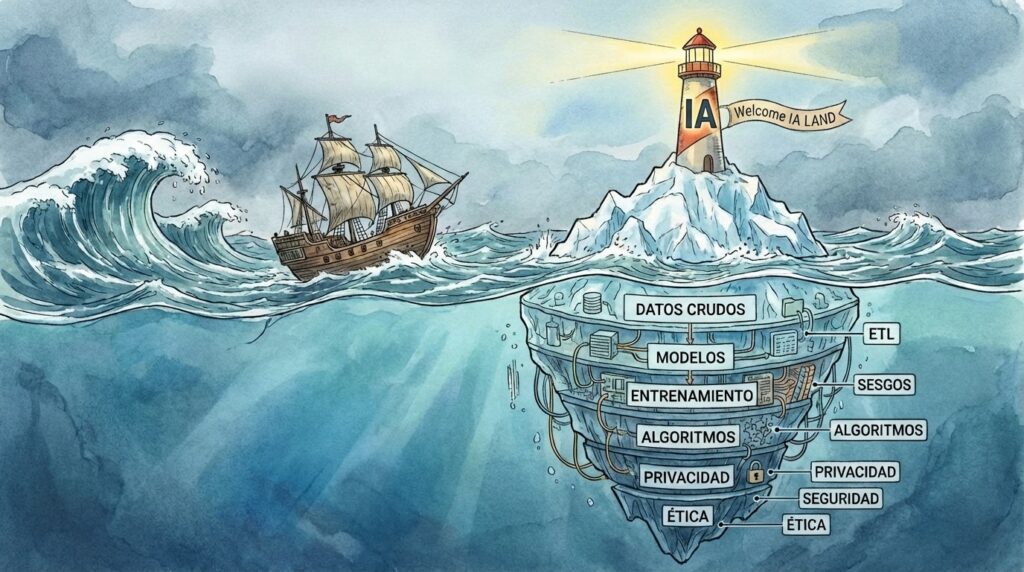

El ciclo de vida del dato: una construcción social.

El “ciclo de vida del dato” va más allá de lo técnico, es una cuestión metodológica. Se refiere a cómo se piensa el dato desde qué evento, web, app, solución, estructura, hasta que llega a un tablero de quien toma la decisión a las 8 de la mañana.

Y aquí hay que decirlo sin vueltas: los datos no existen en la naturaleza esperando ser recolectados. No caen de los árboles como en la anécdota de Newton. Los datos se construyen, se producen, emergen de decisiones metodológicas, técnicas, políticas y éticas que atraviesan todo su proceso de existencia.

Desde la sociología de la ciencia —pensando en autores como Bruno Latour o Donna Haraway— sabemos que todo conocimiento científico, toda “objetividad”, está situada. No hay observación sin observador, no hay medición sin instrumento, no hay dato sin contexto de producción. El ciclo de vida del dato es, entonces, el reconocimiento de que ese dato tiene una biografía, una historia que hay que poder contar y auditar.

Este ciclo tiene etapas que podemos identificar, aunque nunca son lineales ni asépticas:

1. Conceptualización: ¿Qué queremos saber? ¿Qué problema buscamos comprender o resolver? Acá está la primera decisión política: qué merece ser medido y qué no.

2. Diseño metodológico: Cómo vamos a capturar esa información. Qué instrumentos, qué preguntas, qué categorías de análisis.

3. Recolección/Generación: El momento del levantamiento de la información, donde entran en juego las condiciones materiales, los sesgos del relevador, la relación con el relevado.

4. Procesamiento y limpieza: Donde se estandariza, se completa, se decide qué es un “dato válido” y qué no. Acá pueden colarse sesgos enormes.

5. Análisis e interpretación: Dónde los datos se convierten en información, en narrativa sobre lo real.

6. Uso y toma de decisiones: El momento político por excelencia, donde el dato se vuelve acción pública.

7. Archivo y preservación: La memoria del dato, su disponibilidad para auditoría y uso futuro.

En cada una de estas etapas pueden aparecer problemas de confiabilidad, y por eso es imposible pensar políticas públicas medibles a mediano y largo plazo sin datos fiables y confiables. Pero fiables no significa “técnicamente correctos”, sino metodológicamente rigurosos y éticamente transparentes.

La dimensión metodológica: instrumentos y sesgos.

Acá entramos en lo denso, en lo que muchas veces se pasa por alto en la fiebre tecnocrática actual. La metodología importa. Y mucho.

Cuando diseñamos un censo, estamos tomando decisiones sobre categorías clasificatorias que van a producir realidad estadística por años. ¿Preguntamos por “etnia” o por “autopercepción étnica”? ¿Incluimos opciones múltiples o forzamos una única identidad? Cada decisión produce datos distintos y, con ellos, políticas distintas. Los censos argentinos han sido históricamente criticados por la invisibilización de pueblos originarios; los censos estadounidenses por la racialización problemática de categorías como “hispano”.

En las encuestas, el problema del sesgo del instrumento es aún más evidente. La forma en que redactamos una pregunta condiciona la respuesta. El orden de las preguntas genera efectos de contexto. El medio (presencial, telefónico, online) sesga la muestra. Una encuesta de satisfacción ciudadana realizada solo por formulario web excluye a quien no tiene conectividad. Una encuesta presencial en horario laboral excluye a quien no puede ausentarse del trabajo. No hay instrumento neutro.

En el diseño de productos digitales (UI/UX para plataformas de gestión pública), estamos construyendo datos a partir de interacciones. Pero ¿qué registramos y qué no? Si solo medimos “clics” y “tiempo en página”, podemos estar perdiendo información crucial sobre frustración, abandono, confusión. Si nuestro diseño no considera accesibilidad, estamos generando datos sesgados hacia usuarios sin discapacidad. Cada botón, cada formulario, cada flujo de navegación es una decisión metodológica que produce cierto tipo de dato.

Desde la investigación social cualitativa, sabemos que los métodos etnográficos, las entrevistas en profundidad, los grupos focales, generan datos no estructurados que son igual de valiosos —si no más— que las grandes bases numéricas. El problema es que la gestión pública está obsesionada con lo cuantitativo, con el KPI, con el dashboard, y termina invisibilizando dimensiones cualitativas fundamentales para entender lo social.

La antropóloga Joanna Boehnert habla de “data colonialism” para referirse a cómo las formas dominantes de producción de datos reproducen lógicas extractivistas y coloniales: se extrae información de las comunidades sin retorno, sin participación real en el diseño metodológico, sin reconocimiento de sus formas propias de conocimiento. Una gestión pública basada en datos confiables debe incorporar metodologías participativas, donde las comunidades son co-diseñadoras de los instrumentos de medición.

La dimensión política de los datos públicos: seguridad, ética y derechos.

Cuando hablamos de datos para la gestión pública, hay una dimensión distintiva respecto a los datos de un e-commerce o un reporte de un departamento de logística o ventas. Y antes que abramos una discusión sin sentido, se entiende que la dimensión de fidelidad y confiabilidad debe ser tanto o igual de rigurosa en cualquier ámbito. Pero la diferencia está en que si hay datos mal elaborados, gestionados y trabajados de un censo de salud, por ejemplo, puede impactar de forma negativa en la vida de miles o millones de habitantes. Esa dimensión político-técnica es esencial, sobre todo en los ámbitos de la data pública.

Pero además, los datos públicos enfrentan hoy un escenario complejo de amenazas y responsabilidades:

Privacidad y consentimiento informado: Ya no alcanza con “avisar” que se recolectan datos. La Ley de Protección de Datos Personales (en Argentina, Ley 25.326, actualizada constantemente), el GDPR europeo, o leyes equivalentes en otros países, establecen que el consentimiento debe ser específico, informado y revocable. ¿Pero cómo garantizamos esto en un trámite municipal obligatorio? ¿Cómo explicamos en lenguaje accesible qué datos se toman y para qué? Acá aparece una tensión entre la necesidad de información del Estado y los derechos individuales que no se resuelve solo con un “he leído y acepto”.

Seguridad y exposición de datos sensibles: Los casos se multiplican. En 2021, el hackeo de datos de RENAPER en Argentina expuso información de millones de ciudadanos. En 2023, violaciones en sistemas de salud pública en varios países latinoamericanos dejaron expuesta información médica. No es paranoia, es realidad: los sistemas públicos son objetivo permanente de ataques, y las consecuencias pueden ser devastadoras. Desde suplantación de identidad hasta persecución política, discriminación o extorsión.

La protección de datos públicos no puede ser “lo que nos alcanza con el presupuesto”. Requiere inversión en infraestructura, capacitación permanente, auditorías externas, protocolos de respuesta ante incidentes. Requiere entender que la ciberseguridad no es “el técnico de sistemas”, es política de Estado.

Usos secundarios y función creep: Un dato recolectado para un fin termina usado para otro. Datos de programas sociales usados para vigilancia migratoria. Datos de salud usados para scoring crediticio. Datos de educación usados para perfilamiento. La “function creep” —la expansión progresiva del uso de datos más allá de su propósito original— es una amenaza concreta. Las normativas de protección de datos establecen el principio de finalidad: los datos deben usarse para lo que fueron recolectados, punto. Pero en la práctica, la tentación de “ya que tenemos los datos, usémoslos para…” es enorme.

Transparencia algorítmica: Cada vez más decisiones públicas se automatizan. Algoritmos que priorizan denuncias, que asignan recursos, que evalúan riesgo. Pero ¿quién audita esos algoritmos? ¿Cómo sabemos que no reproducen sesgos raciales, de género, de clase? El caso de los algoritmos de detección de fraude en sistemas de asistencia social de Países Bajos, que discriminaban sistemáticamente a minorías étnicas, es una alerta. No puede haber “cajas negras” en la gestión pública. Los algoritmos deben ser auditables, explicables, cuestionables.

Ética en el manejo de poblaciones vulnerables: Cuando trabajamos con datos de infancias, de personas con discapacidad, de víctimas de violencia, de migrantes, el estándar ético debe ser máximo. No solo por normativa, sino porque la asimetría de poder es enorme. La pregunta no es solo “¿es legal?”, sino “¿es justo?”.

Necesitamos avanzar hacia una ética de los datos públicos que incorpore:

- Participación ciudadana en decisiones sobre qué datos recolectar y cómo usarlos

- Mecanismos de reparación cuando hay violaciones

- Auditorías independientes con capacidad sancionatoria

- Capacitación permanente en ética digital para funcionarios públicos

- Divulgación pública de brechas de seguridad (no ocultamiento)

Nuestros desafíos desde el día a día: analistas, desarrolladores, académicos.

Escribo esto desde la posición de quienes hemos trabajado con datos públicos, desde distintos lugares pero con dilemas compartidos. Como analista de datos, como desarrollador, como académico o como quien está en la intersección incómoda de estos roles, enfrentamos tensiones cotidianas que rara vez aparecen en los papers o en las conferencias tech.

La tensión entre urgencia y rigor: Nos piden el dashboard para ayer. El informe tiene que estar para la reunión de mañana. El sistema tiene que estar operativo antes de que termine el mandato. Y sabemos —lo sabemos— que apurar procesos metodológicos producen datos basura. Que un análisis estadístico hecho en dos días con datos sin limpiar puede llevar a decisiones pésimas. Pero ¿cómo negociamos tiempos cuando hay presión política, cuando hay plazos que “no se pueden mover”?

Acá no hay respuesta fácil. A veces cedemos sabiendo que no es lo ideal. A veces ponemos el límite y bancamos el costo. Pero lo importante es no naturalizarlo, no aceptar que “así son las cosas”. Cada vez que entregamos algo que sabemos que podría ser mejor, deberíamos poder documentar por qué, qué faltó, qué riesgos tiene. No como excusa, sino como trazabilidad de las condiciones de producción del dato.

La soledad de las decisiones metodológicas: Cuando estás diseñando una base de datos, cuando estás armando un script de limpieza, cuando estás decidiendo cómo categorizar una variable, muchas veces estás solo. No hay equipo interdisciplinario, no hay tiempo para consultar con especialistas en ciencias sociales, no hay instancia de revisión por pares. Y ahí, en esa soledad, se toman decisiones que van a condicionar todo lo que venga después.

He visto desarrolladores que sin quererlo reproducen sesgos de género porque nadie les explicó que poner “sexo” como campo obligatorio binario es una decisión política. He visto analistas que eliminan outliers sin preguntarse si esos “datos raros” no son justamente las poblaciones más vulnerables. He visto

No es maldad, es falta de formación, de tiempo, de recursos. Pero las consecuencias son reales. ¿Qué hacemos? Necesitamos construir espacios de consulta, de revisión colectiva, de formación permanente. Necesitamos poder decir “no sé” sin que eso sea debilidad. Necesitamos protocolos, pero también criterio para saber cuándo el protocolo no alcanza.

El síndrome del impostor (que a veces es lucidez): Trabajar con datos públicos da vértigo. Porque sabés que lo que hacés puede impactar en vidas concretas. Porque te das cuenta de todo lo que no sabés. Porque entendés que tu formación técnica no te preparó para decisiones éticas complejas.

Y acá viene algo que me parece fundamental: el síndrome del impostor, en nuestro campo, a veces no es un problema psicológico, es sensatez. Es entender la magnitud de la responsabilidad. El problema es cuando ese vértigo nos paraliza, cuando no pedimos ayuda, cuando nos escondemos detrás de “lo técnico” para no hacernos cargo de lo político y ético.

No tenemos que saber todo. Pero sí tenemos que saber cuándo necesitamos a alguien más en la mesa. Cuándo un problema de datos es en realidad un problema de diseño de políticas públicas. Cuándo una decisión técnica requiere debate público.

La precarización del trabajo con datos en el Estado: Hablemos de lo material. En muchos lugares, quienes trabajan con datos públicos están en condiciones de extrema precariedad. Contratos temporales, salarios bajos, sin estabilidad. ¿Cómo construimos institucionalidad, memoria técnica, capacidad instalada, si las personas rotan permanentemente? ¿Cómo pedimos compromiso ético de largo plazo cuando no hay proyección laboral?

Y esto no es un tema menor. La fuga permanente de talento del sector público al privado no es solo cuestión de plata (que también). Es que trabajar en el Estado con datos debería ser visto como lo que es: un trabajo de enorme responsabilidad que requiere profesionales formados y condiciones dignas. No puede seguir siendo “mientras tanto” o “para sumar experiencia”.

El desafío de comunicar complejidad: Nos toca explicar por qué no podemos responder ciertas preguntas con los datos disponibles. Por qué el promedio miente. Por qué correlación no es causalidad. Por qué ese dashboard hermoso puede estar mostrando una realidad distorsionada.

Y acá entra algo que me parece clave: tenemos que aprender a comunicar sin condescender pero sin tecnocratizar. Encontrar el lenguaje que haga accesible la complejidad sin simplificarla hasta la mentira. Porque si no podemos explicar por qué importa la metodología, cómo esperamos que se tome en serio.

La resistencia a la automatización irreflexiva: La presión es constante. “Automaticemos esto”. “Pongamos un algoritmo”. “Hagamos un modelo predictivo”. Y a veces tiene sentido, pero otras veces es entusiasmo tecnológico sin análisis de consecuencias.

Como desarrolladores, como analistas, tenemos que poder decir: este proceso NO debe automatizarse. Esta decisión requiere criterio humano. Este modelo reproduce sesgos inaceptables. Y tenemos que decirlo aunque no sea lo que quieren escuchar, aunque el mercado tech esté vendiendo que todo es automatizable.

No somos anti-tecnología, somos pro-responsabilidad. Y eso implica saber cuándo la tecnología es parte de la solución y cuándo es parte del problema.

Construir comunidad de práctica: Lo que me queda cada vez más claro es que no podemos hacer esto solos. Necesitamos comunidades de práctica, espacios donde compartir dilemas, donde consultar enfoques, donde construir estándares colectivos.

Necesitamos más encuentros entre analistas de datos de distintas áreas del Estado. Más diálogo entre académicos y gestores. Más puentes entre quienes desarrollan y quienes usan esos sistemas. Más transparencia sobre nuestros errores y aprendizajes.

Y esto no es filantropía profesional, es necesidad. Porque los problemas son complejos, los desafíos son enormes, y la única forma de enfrentarlos es colectivamente. Con humildad para reconocer lo que no sabemos, con generosidad para compartir lo que sí, con compromiso para seguir aprendiendo.

El trabajo con datos públicos no es neutro, no es solo técnico, no es aséptico. Es político, es ético, es profundamente humano. Y eso nos exige estar a la altura, todo el tiempo, sabiendo que vamos a equivocarnos pero comprometidos a hacerlo mejor.

No hay recetas. Hay preguntas, tensiones, búsquedas. Y está bien que así sea.

Related Posts

Stay Informed With the Latest & Most Important News

Previous Post

Next Post

Previous Post

Next Post

Recent Posts

- ¿Es momento de un Chief Research Officer?

- Del Click al Servidor: Anatomía de la Medición Digital Moderna

- El iceberg de la IA: momentos para navegar con precaución

- Minería de Datos a Cielo Abierto sin Regulaciones Claras: Desafíos Técnicos y Éticos.

- JAX-Privacy y el nuevo estándar de IA auditable: qué cambia para ingenieros y DPOs (Parte II)