- Home

- Gobierno digital

- Del Click al Servidor: Anatomía de la Medición Digital Moderna

Del Click al Servidor: Anatomía de la Medición Digital Moderna

![]() Claudio MartinezÉtica y algoritmos, Gobierno digital, Analítica Digital11 hours ago24 Views

Claudio MartinezÉtica y algoritmos, Gobierno digital, Analítica Digital11 hours ago24 Views

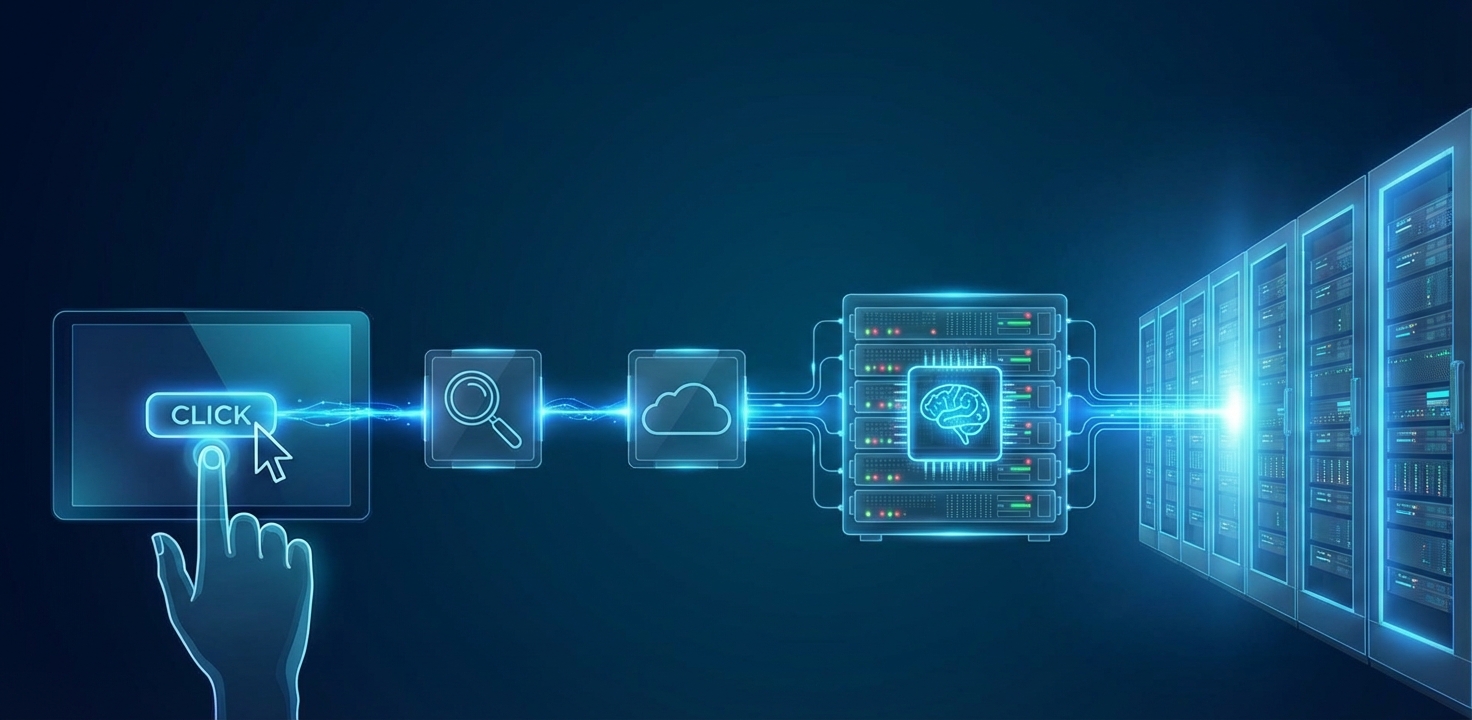

Cada vez que alguien visita tu sitio web, ocurre una coreografía invisible. Se carga HTML, se ejecutan scripts, se disparan eventos, se envían requests a dominios que no siempre controlas. En algún punto, una visita se convierte en un pageview, un clic en un evento, una compra en una conversión. Todo parece funcionar: los dashboards se llenan, los números suben o bajan, y nadie se queja.

Pero si te detienes un segundo y miras bajo el capó, la pregunta incómoda aparece sola: ¿realmente sabemos qué estamos midiendo y cómo están viajando esos datos?

Muchos equipos técnicos heredan implementaciones de tracking como quien hereda una casa vieja: el cableado está ahí, la luz prende, pero nadie sabe muy bien por dónde pasan los cables. Un tag manager configurado hace años, píxeles de terceros cargando en el cliente, requests que se bloquean a veces. Cuando algo falla, la reacción suele ser pragmática: ‘revisemos el tag’. Rara vez se discute la arquitectura completa.

Y sin embargo, esa arquitectura define mucho más de lo que parece. Define qué tan confiables son tus decisiones de producto, cuánta fricción agregás al performance del sitio, qué tan expuesto estás a cambios de navegadores, ad blockers o regulaciones de privacidad.

La medición digital moderna ya no es solo pegar un script y esperar que Google Analytics haga magia. Es un sistema distribuido, con múltiples actores, capas y trade-offs técnicos reales. Si alguna vez dudaste de un número pero no supiste dónde empezar a investigarlo, este tema es para vos.

Cómo funciona realmente el tracking.

Para entender esto, necesitamos ir al navegador, donde todo comienza. El tracking web es JavaScript ejecutándose en el contexto del usuario, capturando señales del entorno y enviándolas a servidores remotos mediante requests HTTP.

Cuando un usuario llega a un sitio, el navegador ejecuta scripts que actúan como sensores. Estos scripts —Google Analytics, Meta Pixel, o cualquier plataforma— leen el contexto técnico que el navegador expone: el User-Agent, la URL de referencia, la resolución de pantalla, la zona horaria, la IP. Son señales ambientales, metadatos del contexto de navegación.

El JavaScript de tracking convierte interacciones en eventos estructurados. Un clic en un botón es un objeto de datos con propiedades: qué elemento fue clickeado, en qué momento, en qué contexto. Aquí aparece el concepto fundamental de seguimiento y medición a través de una capa de datos o DataLayer.

El JavaScript de tracking convierte interacciones en eventos estructurados. Un pageview es el registro de que una página fue cargada. Un evento es cualquier interacción significativa: scroll, clic, envío de formulario, reproducción de video. Ambos son unidades discretas de medición que describen qué pasó, cuándo y bajo qué condiciones.

El dataLayer resuelve la desconexión entre lo que pasa en la página y lo que las herramientas de analytics necesitan saber. Sin dataLayer, cada script tendría que escuchar eventos del DOM directamente e interpretar la estructura HTML. Es frágil y no escala. El dataLayer es una estructura de datos intermedia —típicamente un array de objetos JavaScript— donde la aplicación deposita eventos en formato estandarizado. Cuando un usuario agrega un producto al carrito, el código empuja un objeto al dataLayer con la estructura {event: ‘add_to_cart’, product_id: ‘12345’, value: 49.99}. Los scripts de tracking escuchan cambios en ese dataLayer y reaccionan según reglas configuradas.

Las cookies son el mecanismo de persistencia de identidad. Técnicamente, son pares clave-valor que el navegador almacena y reenvía en cada request al dominio que las emitió. La distinción crítica es first-party versus third-party. Una cookie first-party es emitida por el dominio que visitas —ejemplo.com crea una cookie en ejemplo.com. Una cookie third-party es emitida por un dominio diferente: estás en ejemplo.com pero se carga un script de analytics.com que establece una cookie bajo analytics.com. Los navegadores modernos bloquean third-party cookies por defecto, colapsando ese modelo de identidad persistente entre dominios.

Los tags son fragmentos de código que disparan requests HTTP hacia servidores de analytics. Cuando un evento se registra en el dataLayer y una regla de tag se activa, el tag construye una URL con parámetros codificados. El navegador hace ese request, el servidor recibe los parámetros, los parsea y los almacena. El flujo completo: un usuario hace clic → el event listener captura el clic → empuja un objeto al dataLayer → GTM detecta el objeto y evalúa sus reglas → un tag se ejecuta, construye un request HTTP con todos los parámetros relevantes → se envía a google-analytics.com/collect → el servidor de Google recibe, valida, asocia la cookie con un perfil de usuario, y almacena el evento. Segundos después, ese dato aparece en los reportes.

Google Tag Manager y GA4: el ecosistema estándar.

Gestionar toda esa arquitectura manualmente se volvió insostenible bastante rápido. Cuando cada nuevo proveedor traía su propio snippet, cuando marketing pedía ‘solo un píxel más’ y cada cambio implicaba tocar código y desplegar, el tracking empezó a sentirse como deuda técnica pura.

Ahí aparece Google Tag Manager, no como una genialidad conceptual, sino como una respuesta pragmática a ese caos. La idea era simple: desacoplar la medición del ciclo de desarrollo. En lugar de hardcodear cada tag en el sitio, se inyecta un único contenedor y, desde ahí, se orquesta todo lo demás. Para los equipos técnicos, eso significó menos deploys por cambios de tracking. Para analistas y PMs, significó poder iterar sin pedir permiso cada vez.

Lo interesante es que GTM no ‘simplifica’ la medición tanto como la vuelve gestionable. Los tags dejan de ser scripts sueltos y pasan a ser piezas que se activan bajo ciertas condiciones. Los triggers son la formalización de cuándo debería enviarse un dato. Y las variables conectan el estado real del sitio —lo que vive en el dataLayer, en el DOM o en la URL— con esas decisiones.

En paralelo, Google Analytics también empezaba a quedarse corto. Universal Analytics estaba construido alrededor de sesiones, pageviews y una web bastante más estática que la actual. Forzar aplicaciones modernas o flujos complejos de usuario dentro de ese modelo era posible, pero cada vez más artificial.

GA4 nace de esa fricción. No como un rediseño estético, sino como un cambio de modelo mental. Todo es un evento. Una página vista, un clic, un scroll, una compra o un paso intermedio en un funnel comparten la misma lógica básica: algo ocurrió, con ciertos parámetros asociados. Esto encaja mucho mejor con cómo ya pensaban los equipos técnicos y con cómo GTM venía estructurando los datos.

Cuando GTM y GA4 se usan juntos, la integración se siente natural. GTM se convierte en el punto donde se decide qué eventos existen y cuándo se disparan; GA4 en el sistema que los recibe, normaliza y conecta con usuarios y dispositivos. Por eso este ecosistema se volvió el estándar de facto. No porque sea perfecto, sino porque refleja cómo evolucionó la web y cómo trabajan hoy los equipos.

El problema de privacidad y compliance.

Esta arquitectura, por elegante que sea técnicamente, plantea problemas serios cuando la miras desde compliance. El client-side tracking, por diseño, opera fuera del control directo de la organización: ejecuta código de terceros en el navegador del usuario, transmite datos a servidores extranjeros, y confía en que Google honrará las políticas de privacidad declaradas. Esa confianza, desde protección de datos, es un riesgo material.

El primer problema es la fuga de datos personales que ocurre sin diseño intencional. URLs con parámetros que contienen identificadores de usuario, correos electrónicos en query strings después de un login fallido, números de documento en formularios. GA4 captura automáticamente la URL completa de cada pageview. Si tu aplicación pasa datos sensibles por GET, esos datos viajan directo a Google sin que nadie haya tomado la decisión consciente de compartirlos.

Las transferencias internacionales de datos son implícitas. Cuando un usuario en Chile carga una página con GA4, sus datos —IP, identificadores de sesión, metadatos— se transmiten a servidores de Google que pueden estar en Estados Unidos, Irlanda, o cualquier región donde Google opere. Bajo la Ley 21.719 chilena, esa transferencia requiere base legal explícita. Bajo GDPR, después de Schrems II, las transferencias a Estados Unidos quedaron en zona gris legal. La organización promedio que implementa GTM/GA4 no ha hecho esa evaluación.

Desde seguridad, el client-side tracking amplifica la superficie de ataque. Cada script de tercero que se carga es código que no controlas ejecutándose con los mismos privilegios que tu aplicación. Los tags mal configurados pueden exponer cookies de sesión, tokens CSRF, o datos de autenticación.

Cuando audito una implementación de GTM/GA4, veo una arquitectura donde la organización ha delegado el control de datos personales a un sistema que opera como caja negra. No puedes verificar qué hace Google con los datos una vez que llegan a sus servidores. No puedes garantizar que IPs realmente se anonimizan antes de almacenarse. No tienes logs de auditoría completos. Para un DPO, eso es insuficiente cuando tienes que responder ante una autoridad de protección de datos.

Server-side tagging: repensar la arquitectura.

La respuesta técnica implica repensar dónde procesamos los datos antes de enviarlos a terceros. Server-side tagging invierte la arquitectura tradicional: en lugar de que el navegador dispare requests directos a Google, Meta y otros vendors, todos esos requests pasan primero por un servidor intermedio que controlas. Ese servidor actúa como proxy inteligente, recibiendo eventos del cliente, procesándolos según reglas que defines, y luego distribuyéndolos a los destinos finales.

Técnicamente, Google Tag Manager Server Container es una instancia de GTM que corre en tu infraestructura —App Engine, Cloud Run, o cualquier entorno que soporte contenedores Docker— en vez de ejecutarse como JavaScript en el navegador. El navegador envía eventos a una URL que tú controlas, como https://analytics.tudominio.com/collect. Ese endpoint recibe el payload, lo parsea, y ejecuta tags server-side que pueden transformar datos, agregar contexto desde bases de datos internas, eliminar campos sensibles, y luego reenviar requests a los APIs de destino.

La diferencia fundamental está en el punto de decisión. En client-side, el JavaScript de Google decide qué capturar. En server-side, tu código toma esa decisión. Ejemplo: un usuario completa una compra y el dataLayer registra {event: ‘purchase’, email: ‘usuario@example.com’, value: 150}. En client-side, ese objeto viaja completo a GA4 si el tag está mal configurado, exponiendo el email. En server-side, el contenedor recibe el evento, detecta el campo email, lo hashea con SHA-256, lo reemplaza por el hash, y envía los datos sanitizados. También puede registrar el evento original en BigQuery bajo tu control antes de hacer cualquier envío externo.

El enriquecimiento de datos es otra dimensión que server-side habilita. Puedes cruzar el user_id con tu CRM y agregar segmentos de cliente antes de enviar a plataformas de marketing. Puedes consultar APIs internas para verificar si un usuario tiene consentimiento válido y bloquear envíos a vendors específicos si no lo tiene. Puedes normalizar datos entre diferentes fuentes.

Desde compliance, server-side cambia la narrativa en auditorías. Ahora puedes demostrar que los datos personales se procesan en infraestructura europea —o chilena— antes de cualquier transferencia internacional. Puedes implementar sanitización automática de PII según políticas centralizadas. Puedes generar logs completos de cada evento enviado, con timestamp, origen, destino y transformaciones aplicadas, que sirven como evidencia para autoridades de protección de datos.

Pero esta arquitectura tiene costos reales. La complejidad de implementación sube considerablemente. Necesitas provisionar infraestructura, configurar redes, manejar certificados SSL, monitorear uptime, escalar según tráfico. Un sitio con millones de eventos al día generará costos de compute y bandwidth que en client-side eran cero. Necesitas desarrolladores que entiendan server-side rendering, APIs de vendors, y arquitectura de eventos. Debuggear problemas es más complejo: ahora revisas logs de servidor, latencia de red, y errores de API además de issues en el navegador.

Decisiones arquitectónicas.

Después de recorrer todo este camino, la sensación más honesta es que medir bien no es una cuestión de herramientas, sino de decisiones. Cada arquitectura de medición es una forma de decir qué problemas estás dispuesto a asumir y cuáles no.

Antes de mover tracking al server o de mantenerlo en el cliente, conviene hacerse preguntas que no aparecen en la documentación. Qué nivel de control necesitás realmente sobre los datos y para qué. Cuánto ruido estás dispuesto a tolerar en nombre de la simplicidad. Si el costo operativo de una infraestructura más robusta se justifica por el impacto que esos datos tienen en decisiones reales de negocio o producto. Y, sobre todo, si el equipo que va a sostener esto tiene tiempo y contexto para hacerlo bien dentro de seis meses, no solo hoy.

El server-side tagging suele presentarse como una respuesta elegante a problemas reales de privacidad, bloqueo y pérdida de señal. Y lo es, en muchos casos. Pero también introduce nuevas superficies de fallo y responsabilidades que no desaparecen por arte de magia. Pasar más control al backend implica asumir más ownership, no menos.

Algo similar pasa con el compliance. No se trata de cumplir por cumplir, sino de entender qué riesgos existen de verdad en tu caso y qué expectativas tienen tus usuarios, tus partners y tu industria. A veces una solución más simple, bien entendida y bien documentada, genera menos fricción que una arquitectura sofisticada que nadie domina del todo.

La buena medición no se nota cuando funciona, pero se vuelve obvia cuando falla. Diseñarla con criterio técnico, entendiendo límites y costos, es una forma de respeto tanto por los datos como por el equipo que va a convivir con ellos.

Related Posts

Stay Informed With the Latest & Most Important News

Previous Post

Next Post

Previous Post

Next Post

Recent Posts

- Del Click al Servidor: Anatomía de la Medición Digital Moderna

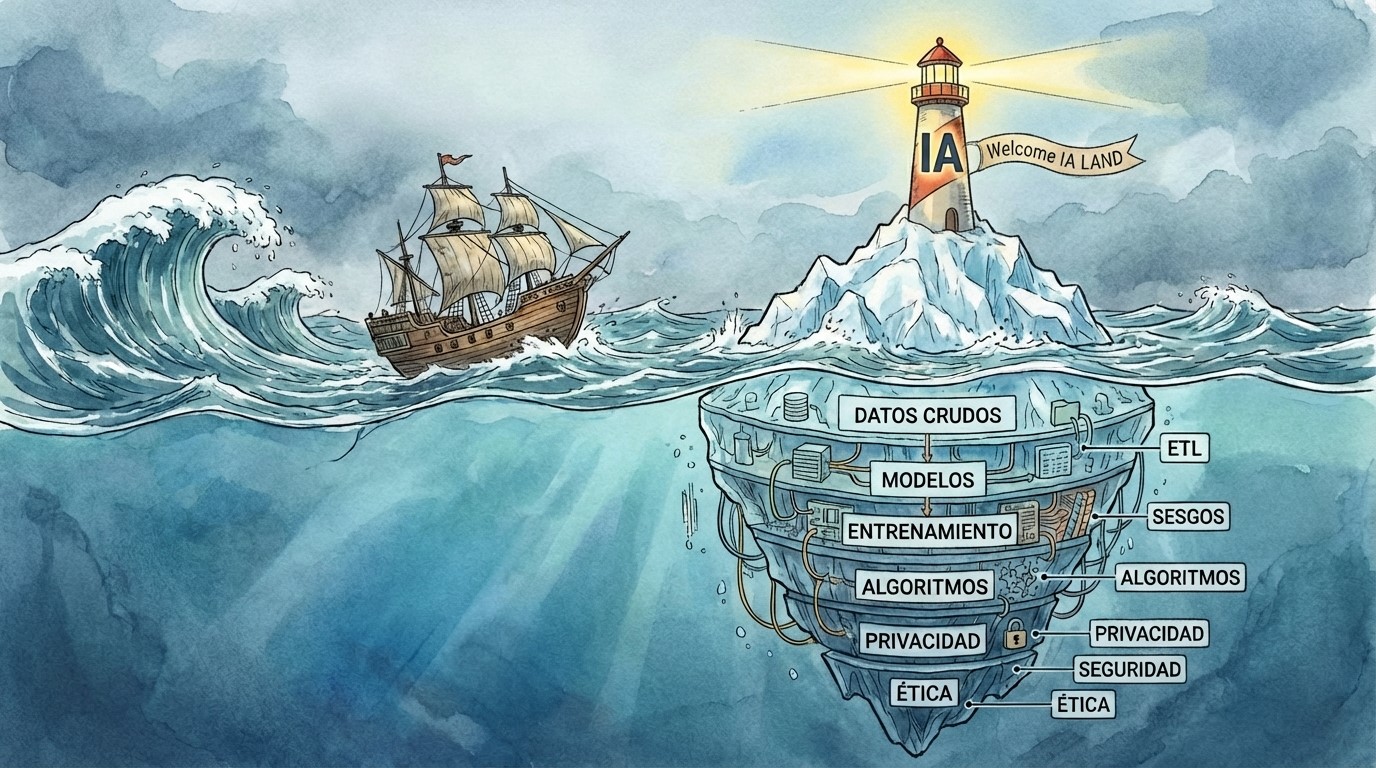

- El iceberg de la IA: momentos para navegar con precaución

- Minería de Datos a Cielo Abierto sin Regulaciones Claras: Desafíos Técnicos y Éticos.

- JAX-Privacy y el nuevo estándar de IA auditable: qué cambia para ingenieros y DPOs (Parte II)

- JAX-Privacy y el nuevo estándar de IA auditable: qué cambia para ingenieros y DPOs (Parte I)