- Home

- Machine learning

- Abramos la caja negra de la IA: por qué la interpretabilidad es clave para una IA generativa segura y confiable.

Abramos la caja negra de la IA: por qué la interpretabilidad es clave para una IA generativa segura y confiable.

![]() Claudio MartinezMachine learning, Ética y algoritmos, Inteligencia Artificial4 months ago429 Views

Claudio MartinezMachine learning, Ética y algoritmos, Inteligencia Artificial4 months ago429 Views

Mientras esperaba el despegue de mi vuelo desde Córdoba hacia Buenos Aires, no pude evitar pensar en las cajas negras de los aviones. Esos dispositivos que, tras cada accidente, nos revelan qué ocurrió en los momentos críticos. Pero ¿qué pasaría si pudiéramos “abrir la caja negra” antes del accidente? ¿Si pudiéramos entender el funcionamiento interno de sistemas complejos antes de que fallen? Esta reflexión me llevó inevitablemente a otra caja negra mucho más presente en nuestras vidas: la inteligencia artificial.

ChatGPT, Claude, Gemini, DALL·E, Sora… estos nombres nos resultan cada vez más familiares. La IA generativa ha pasado de ser una curiosidad tecnológica a una herramienta cotidiana que ayuda a millones de personas a escribir, programar, crear imágenes y tomar decisiones. Sin embargo, existe una pregunta fundamental que pocas veces nos hacemos: ¿podemos realmente confiar en sistemas cuyo funcionamiento interno no comprendemos?

El enigma de la caja negra digital.

La IA generativa moderna funciona de manera radicalmente distinta al software tradicional. Cuando un programador escribe código convencional, cada línea tiene un propósito específico y predecible. En cambio, los modelos de lenguaje y las redes neuronales profundas son sistemas que “aprenden” patrones a partir de billones de datos, creando conexiones que ni siquiera sus creadores pueden explicar completamente.

Como señala Dario Amodei, director ejecutivo de Anthropic, cuando un sistema de IA generativa hace algo —como resumir un documento financiero— no sabemos, a un nivel específico o preciso, por qué toma las decisiones que toma, por qué elige ciertas palabras sobre otras, o por qué ocasionalmente comete errores a pesar de nuestros esfuerzos.

Esta opacidad no es un detalle técnico menor: es un desafío fundamental que nos afecta a todos.

Interpretabilidad versus explicabilidad: abriendo el diccionario de la IA.

Antes de avanzar, es crucial distinguir dos conceptos que a menudo se confunden:

Interpretabilidad se refiere a entender cómo funciona el modelo internamente, cómo procesa la información en sus capas neuronales, qué patrones reconoce y cómo llega a sus conclusiones. Es como poder “ver dentro” del cerebro artificial.

Explicabilidad, en cambio, consiste en justificar los resultados hacia el usuario final de manera comprensible, sin necesariamente revelar todos los mecanismos internos.

Para hacerlo más tangible: imagina que la IA es como un chef experto. La explicabilidad sería cuando te dice “usé estos ingredientes y esta técnica”. La interpretabilidad sería entender por qué su paladar detecta ciertos sabores, cómo su experiencia influye en cada decisión, y qué procesos mentales lo llevan a elegir un ingrediente sobre otro.

Los investigadores han desarrollado técnicas como los “sparse autoencoders” (autocodificadores dispersos) para descubrir “características monosemánticas” en los modelos, es decir, patrones neuronales que responden a conceptos específicos y comprensibles. Es como identificar qué neuronas artificiales se activan cuando el modelo piensa en “puentes”, “medicina” o “emociones negativas”.

Por qué importa: cuando la opacidad se vuelve peligrosa.

La opacidad de los sistemas de IA está en la raíz de muchos de los riesgos y preocupaciones asociados con la inteligencia artificial generativa, problemas que serían mucho más fáciles de abordar si los modelos fueran interpretables. Veamos tres áreas donde esta falta de transparencia ha tenido consecuencias tangibles:

Sesgos sistémicos en la justicia

En 2016, ProPublica reveló que COMPAS, un algoritmo utilizado por tribunales estadounidenses para evaluar el riesgo de reincidencia de los acusados, calificaba a los acusados negros como de alto riesgo casi el doble de veces que a los acusados blancos, incluso cuando los perfiles eran similares. El sistema, una verdadera caja negra protegida por secreto comercial, influía en decisiones sobre libertad condicional y sentencias sin que jueces ni acusados pudieran comprender su lógica interna.

Discriminación automatizada en recursos humanos

Entre 2014 y 2017, Amazon desarrolló una herramienta de IA para filtrar currículums que terminó discriminando sistemáticamente a las mujeres. El sistema penalizaba términos como “capitana del club de ajedrez femenino” y devaluaba a graduadas de universidades exclusivamente femeninas. La empresa abandonó el proyecto cuando comprendió que no podía garantizar que el algoritmo fuera neutral en todos los aspectos.

Errores en diagnósticos médicos

La implementación de herramientas de IA en diagnóstico médico ha demostrado que, aunque estos sistemas pueden aumentar la precisión y eficiencia, su uso inevitablemente introduce nuevos tipos de errores, fundamentalmente clasificaciones incorrectas realizadas por algoritmos computacionales. Cuando un médico no puede entender por qué la IA recomienda cierto tratamiento, la confianza y la seguridad del paciente quedan comprometidas.

Estos no son casos aislados, sino síntomas de un problema estructural: sistemas opacos que toman decisiones con impacto real sobre la vida de las personas.

Los avances recientes: iluminando la oscuridad.

La buena noticia es que la ciencia de la interpretabilidad está avanzando rápidamente. En los últimos años, hemos presenciado avances significativos:

En octubre de 2023, Anthropic publicó un trabajo pionero demostrando que los autocodificadores dispersos podían extraer características interpretables de modelos de lenguaje. Utilizando este método en un transformer de una capa, lograron descomponer las activaciones del modelo en unidades más comprensibles.

Ocho meses después, en mayo de 2024, el mismo equipo de Anthropic escaló esta técnica a Claude 3 Sonnet, un modelo de producción de tamaño medio, encontrando millones de características altamente abstractas y multilingües que responden a conceptos específicos y causan comportamientos particulares. Descubrieron, por ejemplo, características separadas que se activan ante textos e imágenes relacionados con el Puente Golden Gate, la neurociencia o atracciones turísticas populares.

Otros laboratorios también están contribuyendo: Google DeepMind ha explorado el análisis de “circuitos neuronales” en modelos de lenguaje, buscando entender cómo fluye la información a través de las capas de procesamiento. OpenAI trabaja en “interpretabilidad mecanicista” para detectar comportamientos emergentes antes de que se vuelvan problemáticos.

Como afirma Amodei, es posible que logremos desarrollar algo así como una “resonancia magnética para la IA” antes de que los modelos alcancen un nivel abrumador de poder, pero debemos movernos rápido si queremos que la interpretabilidad madure a tiempo para importar.

Interpretabilidad y seguridad: un matrimonio necesario

La interpretabilidad no es solo un ejercicio académico fascinante; es una herramienta fundamental para construir sistemas de IA más seguros:

Detección temprana de riesgos. Si podemos “ver” dentro de un modelo, podemos identificar intenciones no deseadas o capacidades peligrosas antes del despliegue masivo. En experimentos recientes en Anthropic, equipos “azules” utilizaron herramientas de interpretabilidad para identificar exitosamente problemas de alineación deliberadamente introducidos por equipos “rojos” en modelos de prueba.

Cumplimiento regulatorio. El AI Act de la Unión Europea, que entró en vigor el 1 de agosto de 2024 y será plenamente aplicable en agosto de 2026, establece obligaciones estrictas para proveedores y usuarios de sistemas de IA según el nivel de riesgo. Para muchas aplicaciones de alto riesgo —en salud, justicia o finanzas—, la interpretabilidad no es opcional: es un requisito legal.

Confianza pública. En un mundo donde la IA toma decisiones sobre préstamos, contrataciones, diagnósticos y recomendaciones de contenido, la capacidad de explicar y auditar estas decisiones es esencial para mantener la confianza del público y la rendición de cuentas democrática.

Auditoría y gobernanza: el eslabón crítico entre tecnología y sociedad.

Aquí radica un desafío que trasciende lo puramente técnico: ¿cómo auditamos lo que no podemos entender? Esta pregunta es especialmente urgente cuando la IA se despliega en sectores públicos y sociales, donde las decisiones automatizadas afectan derechos fundamentales.

Como profesionales de protección de datos y privacidad sabemos que la gobernanza efectiva requiere tres pilares: marcos normativos claros, herramientas técnicas de auditoría, y procesos documentados de rendición de cuentas. La interpretabilidad es el fundamento que sostiene estos tres pilares.

Marcos de auditoría interpretable. Necesitamos urgentemente desarrollar estándares y metodologías que permitan a auditores independientes —no solo a los equipos que desarrollan la IA— verificar el comportamiento de estos sistemas. Esto implica crear protocolos de evaluación que puedan detectar sesgos ocultos, fallos de seguridad o desviaciones de los objetivos declarados, sin necesidad de acceso completo al código fuente protegido.

Herramientas para reguladores y DPOs. Los responsables de protección de datos, autoridades de control y organismos reguladores enfrentan un problema práctico: regular tecnología que evoluciona más rápido que su capacidad de comprenderla. La interpretabilidad debe traducirse en herramientas operativas que permitan a estos actores realizar evaluaciones de impacto, análisis de riesgos y verificaciones de cumplimiento de manera efectiva.

Trazabilidad y documentación. En el ámbito público —educación, salud pública, servicios sociales, administración de justicia— la exigencia de transparencia no es negociable. Cuando un sistema de IA determina quién recibe una prestación social, qué estudiantes necesitan apoyo adicional, o cómo se asignan recursos sanitarios, debe existir un registro auditable del proceso de decisión. Sin interpretabilidad, esta trazabilidad es imposible.

El caso COMPAS es instructivo: la protección del algoritmo como secreto comercial impidió el escrutinio público necesario en un sistema que afectaba libertades fundamentales. Esta situación es inaceptable en democracias que valoran el estado de derecho. La interpretabilidad no es solo deseable, es un prerrequisito para la legitimidad democrática de la IA en el sector público.

Un llamado a la acción institucional. Las organizaciones que implementan IA en contextos sensibles deben invertir no solo en capacidades técnicas, sino en marcos de gobernanza robustos. Esto incluye evaluaciones de impacto algorítmico, comités de ética en IA, mecanismos de reclamación accesibles para ciudadanos afectados, y auditorías periódicas por terceros independientes. Todo esto, sin interpretabilidad, queda reducido a ejercicios superficiales sin sustancia real.

Mirando hacia el futuro: los desafíos pendientes.

A pesar de los avances, quedan enormes desafíos por resolver. La escalabilidad es uno de los más urgentes: los modelos más avanzados tienen cientos de miles de millones de parámetros, y descifrar su funcionamiento es como intentar entender el cerebro humano neurona por neurona.

Los modelos multimodales —que procesan texto, imágenes, audio y video simultáneamente— presentan complejidades adicionales. ¿Cómo interpretamos un sistema que “piensa” en múltiples tipos de información a la vez?

También existe una tensión inevitable entre transparencia total y protección de la propiedad intelectual o la privacidad de los datos de entrenamiento. No todas las “cajas negras” pueden abrirse completamente sin consecuencias.

Sin embargo, como sociedad, no podemos permitirnos el lujo de la ignorancia. Los próximos 5 a 10 años serán cruciales. La comunidad científica, las empresas tecnológicas y los reguladores deben colaborar para que la interpretabilidad avance al ritmo del desarrollo de capacidades.

Abrir la caja no es detener el progreso.

Existe un mito peligroso: que exigir interpretabilidad “frenaría” la innovación en IA. Pero esta es una falsa dicotomía. Como bien señala Amodei: no podemos detener el autobús del progreso tecnológico, pero sí podemos dirigirlo.

Abrir la caja negra de la IA no significa renunciar a su potencial transformador. Significa asegurarnos de que ese poder se ejerza de manera responsable, comprensible y al servicio de todos. Significa que cuando un sistema de IA nos dice “confía en mí”, podamos verificar por qué deberíamos hacerlo.

La interpretabilidad es el puente entre el poder tecnológico y la responsabilidad humana. Es la garantía de que, mientras navegamos hacia un futuro cada vez más automatizado, mantenemos el timón en nuestras manos. Y eso, definitivamente, vale la pena el esfuerzo.

Related Posts

Stay Informed With the Latest & Most Important News

Previous Post

Next Post

Recent Posts

- ¿Es momento de un Chief Research Officer?

- Del Click al Servidor: Anatomía de la Medición Digital Moderna

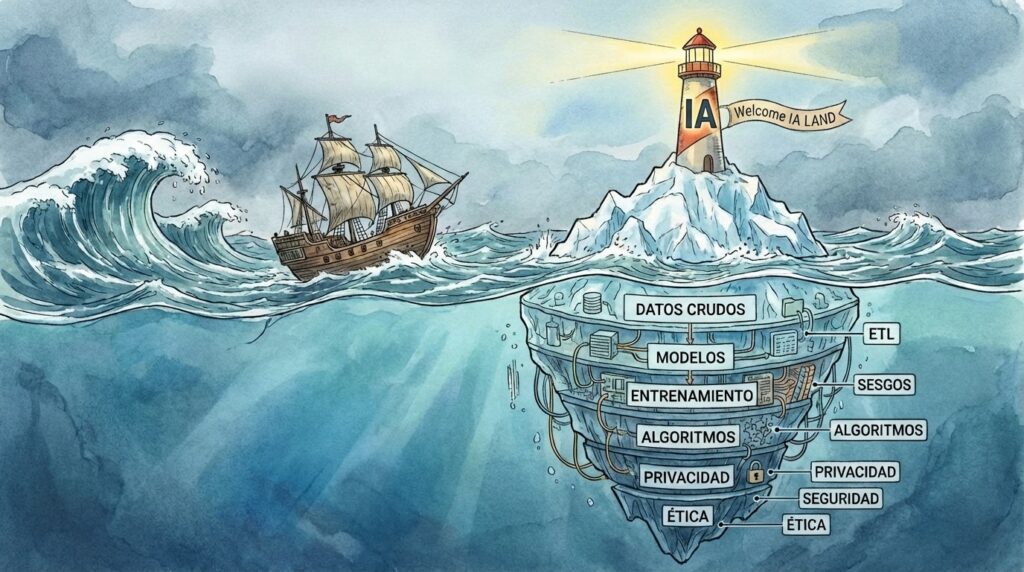

- El iceberg de la IA: momentos para navegar con precaución

- Minería de Datos a Cielo Abierto sin Regulaciones Claras: Desafíos Técnicos y Éticos.

- JAX-Privacy y el nuevo estándar de IA auditable: qué cambia para ingenieros y DPOs (Parte II)